AptX Adaptive

- Windows 11 이후로는 Bluetooth Audio 기본 코덱으로 AAC가 사용 됨

- Windows 11 24H2 부터 AptX Adaptive를 지원하지만 사용 조건이 명확하지 않음

* aptX Adaptive는 Qualcomm Bluetooth 무선 장치가 장착된 일부 Windows 기기에서만 지원됩니다.

- Qualcomm 기반 블루투스 모듈(M.2, QCNFA765)에서도 스펙시트에는 지원으로 표기되나 드라이버에서 AptX를 지원하지 않음

- Windows 에서 AptX Adaptive를 사용하기 위한 쉬운 방법은 오디오장치로 인식 되는 BT-W6, BTD600, CM668등을 사용하면 됨

- 오디오 장치형 동글을 사용하게 되면 블루투스 스택을 사용하지만 동글과 헤드셋이 연결 되는 구조임 (일반 블루투스 연결 불가)

- AptX Adaptive는 AptX 하위 코덱을 포함한다고 하지만 실제로는 지원하지 않음 -> AptX* 버전명이 정확하게 맞지 않으면 안 됨

- DELL 노트북용 드라이버(Intel AX용)을 사용 하면 AptX 가 적용된다고 확인 했지만, 너무 오래된 버전이라 시도 안 해봤음

- Windows 레지스트리 변경으로 기본(AAC)를 비활성화 할 수 있고,AptX로 바뀐다는 글도 있으나 테스트 결과 QC Ultra가 SBC로 연결 됐음

- Qualcomm Snapdrogon 이 탑재된 Windows 11 Arm 계열에서는 AptX Adaptive가 지원 되는 것으로 알고 있음

LDAC

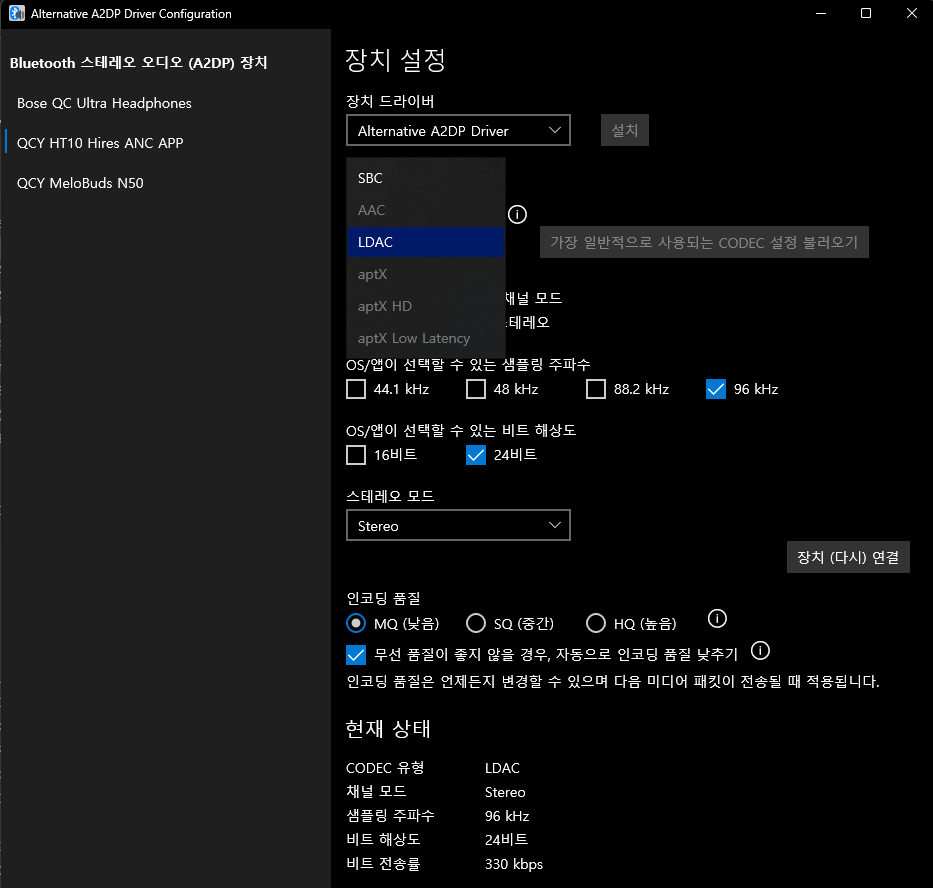

- LDAC 를 사용하려면 Alternative A2DP Driver (유료)를 통해서 활성화 가능함 : https://www.bluetoothgoodies.com/a2dp/

- 대체 A2DP 드라이버에 LDAC+AAC 버전을 변도로 판매 하지만 Windows 11에서 AAC를 기본 제공하기에 AAC는 불필요하다 판단됨

- 대체 A2DP 드라이버에서 트라이얼 기간이 만료 되기전에 구매하면 정가(9.99)보다 조금 더 저렴하게 구매할 수 있음

- 대체 A2DP 드라이버를 통해 장치 별로 코덱을 설정할 수 있음

예시> A는 Windows 드라이버 (AAC), B장치는 A2DP 드라이버 (LDAC) C장치는 A2DP 드라이버 (SBC) 등으로 개별 설정할 수 있음

- 현재 연결 된 코덱 정보는 Bluetooth Tweaker (마찬가지로 일정기간 사용 후 유료 구매)로 확인할 수 있음

결론

- 헤드셋에서 지원할 경우 LDAC를 활성화 할 수(무료는 아님) 있지만, 비트레이트가 높아짐에 따라 배터리 소모가 커짐 = 러닝 타임 줄어듬.

- 어차피 Youtube 에서만 듣는데, LDAC 나 AptX 가 무슨 소용이냐...현타와서 QCY 멜로버즈 N50 하나 더샀음..(??)

- Bose QC Ultra 에서 SBC/AAC/Aptx Adaptive 모든 코덱으로 테스트 해봤는데, SBC는 확실히 구분 가능. AAC/AptX 는 취향 차이인듯

- AptX 가 더 섬세한 소리를 들려주긴 하지만, 낮은 레이턴시(게이밍)가 목적이 아니라면 AAC로 만족할 수도 있을듯 함

- 헤드셋 재연결 시 볼륨이 100%로 시작하는 경우가 있었는데(UGREEN CM668에서) 비슷한 리포트를 봐서는 Windows 24H2의 버그인듯